El siguiente paso fué descubrir las propiedades y estructura del átomo como entidad individual, lo que dió lugar al nacimiento de la

Física Atómica. Tales investigaciones condujeron, entre otros, al descubrimiento del

electrón en 1897 por

Joseph John Thomson, quién imaginó al átomo como una diminuta nube de electrones sobre una esfera de carga positiva. Un año después, el físico francés

Henri Becquerel se encontró con un hecho sorprendente: algunos átomos parecían cambiar de una especie a otra, transmutarse espontáneamente. Esta observación fue interpretada acertadamente como que algunos átomos son inestables y supuso el descubrimiento de la radioactividad natural en 1898.

Marie y

Pierre Curie estudiaron el proceso durante los años siguientes e identificaron varios elementos radioactivos naturales: el

Polonio (Po) y el

Radio (Ra).

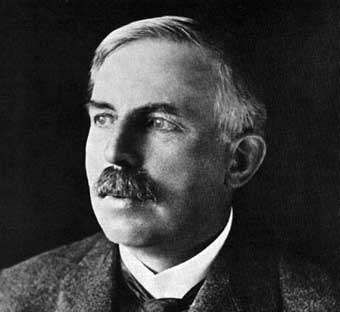

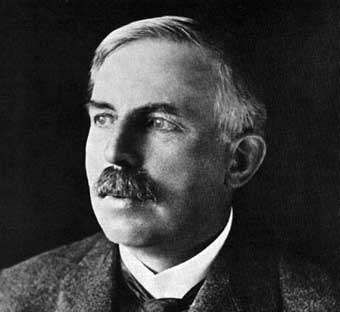

El físico inglés

Ernest Rutherford volvió a dar otro salto y se dedicó a investigar las propiedades y naturaleza de las

radiaciones: las clasificó en alfa (átomos de helio ionizados), beta (electrones) y gamma (fotones). Tras llegar a una comprensión “satisfactoria” (no por ello totalmente cierta), utilizó las radiaciones naturales como sondas para investigar la estructura de la materia. Bombardeando láminas de oro extremadamente delgadas con partículas alfa descubrió que la mayor parte de ellas atravesaban las láminas sin deflectarse. Midió con acierto que la materia, y por tanto el átomo, está prácticamente “hueca”. Sin embargo, un reducido número de partículas alfa encontraban en su trayectoria algo que las hacía dispersarse [1]. Contrariamente a la teoría atómica de Thomson, vigente en aquellos momentos, el resultado de sus medidas permitió concluir que la masa de la materia debía concentrarse en una región muy reducida en tamaño, a la que llamó núcleo; el átomo pasó pues a entenderse como un sistema solar en miniatura, con un núcleo de carga positiva en el centro haciendo las labores de sol y electrones orbitando a su alrededor como planetas ligados mediante la fuerza de atracción eléctrica.

Las medidas de Rutherford desvelaron una terra incógnita para las mentes de la época y dieron luz a la

Física Nuclear, la rama de la física que se encarga de estudiar los núcleos atómicos. En pocos años, se sucedieron importantes descubrimientos y la concepción del mundo subatómico cambió profundamente. Filosóficamente, la

Física Cuántica [2], impulsada por

Max Planck, Albert Einstein,

Niels Bohr y

Erwin Schrodinger, entre otros, acabó con el determinismo mecanicista de finales del siglo XIX y proporcionó una visión probabilística del átomo en particular y del mundo microscópico en general. En el campo de la experimentación, el descubrimiento del

neutrón (

James Chadwick en 1932) tuvo un gran impacto y ayudó a

Werner Heisenberg a explicar el núcleo atómico formado por neutrones (sin carga eléctrica) y

protones (con carga eléctrica positiva).

El descubrimiento del neutrón y la investigación de sus interacciones con la materia dieron paso al que probablemente sea el hallazgo de la física con mayor impacto social en el siglo XX. En 1938,

Lise Meitner,

Otto Hahn y

Fritz Strassman observaron que los átomos de

uranio (símbolo químico U) se separan -fisionan- en dos fragmentos de masas parecidas cuando se bombardean con neutrones. Posteriormente, comprobaron que el proceso de fisión viene acompañado de una emisión de neutrones (2.3 en media para el uranio) y que libera una enorme cantidad de energía. El físico húngaro-estadounidense

Leo Szilard fue el primero en darse cuenta de las tremendas implicaciones del hallazgo, pero cuestionó su viabilidad.

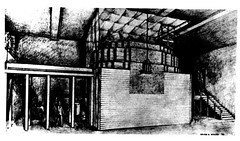

Enrico Fermi no tardó demasiado en plasmar la simple y brillante idea: aprovechar los neutrones emitidos en una fisión para mantener una reacción en cadena de fisiones y utilizar el proceso como fuente de energía. El concepto se vió materializado en Diciembre de 1942:

PILE-1, el primer reactor nuclear del mundo construido por Fermi y colaboradores, entraba en operación en la universidad de Chicago.

En paralelo al uso pacífico de la energía nuclear, algunas mentes fueron fraguando la idea de desarrollar un arma -bomba- que aprovechase tan ingentes cantidades de energía. Corrían tiempos de guerra por Europa, y el temor de muchos científicos refugiados en EEUU a que el régimen nazi desarrollara tal arma con anterioridad les animó a tomar la iniciativa. El horror ante los nazis estaba muy fresco en sus conciencias y consideraron una prioridad absoluta detener a Hitler, a cualquier precio.

Albert Einstein, convencido por Leo Szilard y

Eugene Wigner, utilizó su imágen pública e influencia y urgió al presidente Roosevelt a adelantarse a los alemanes en la carrera por la bomba. El resultado fue el

proyecto Manhattan, que logró su objetivo y condujo a los bombardeos de Hiroshima (“

little boy“, bomba de uranio) y Nagasaki (“

fat man“, una bomba de

plutonio). Einstein, que nunca pensó que las bombas serían utilizadas en la guerra, se vió muy afectado por la atrocidad aprobada por el presidente Truman (sucesor del fallecido Roosevelt). Cinco meses antes de su muerte, Einstein escribía la siguiente frase: “cometí un gran error en mi vida… cuando firmé la carta para el presidente Roosevelt recomendando el desarrollo de la bomba atómica, pero hubo una cierta justificación – el peligro de que los alemanes la hicieran antes.”

La evolución posterior de la física nuclear ha venido marcada por estos hechos. No importan los tremendos logros conceptuales o lo beneficiosos que han sido los desarrollos civiles y pacíficos asociados a ella: la producción de energía, las terapias contra el cáncer, desarrollos tecnológicos como los primeros ordenadores, entre otros. La percepción que la opinión pública tiene de lo “nuclear” es irracionalmente negativa y hará falta tiempo y educación para que adquiera una cierta perspectiva. Es mi intención que la comprensión y exposición correcta de los hechos en esta bitácora nos lleve, sin embargo, a una conclusión bien distinta. Que vivimos en un mundo “nuclear”, rodeado de la radiación natural que contribuyó a nuestro nacimiento como especie (a través de mutaciones); que lo nuclear ha supuesto y supone beneficios netamente positivos para el desarrollo de la humanidad y que seguirá teniendo un papel destacado a la hora de afrontar los serios retos que se le plantean a la humanidad.

Primeros experimentos

Primeros experimentos

La

radiactividad fue descubierta en las sales de

uranio por el físico francés

Henri Becquerel en

1896.

En

1898, los científicos

Marie y

Pierre Curie descubrieron dos elementos radiactivos existentes en la naturaleza, el

polonio (

84Po) y el

radio (

88Ra).

En

1913 Niels Bohr publica su modelo de

átomo, consistente en un

núcleo central compuesto por partículas que concentran la práctica mayoría de la masa del átomo (neutrones y protones), rodeado por varias capas de partículas cargadas casi sin masa (

electrones). Mientras que el tamaño del átomo resulta ser del orden del

angstrom (10

-10 m), el núcleo puede medirse en

fermis (10

-15 m), o sea, el núcleo es 100.000 veces menor que el átomo.

Ernest Rutherford en el año

1918 definió la existencia de los núcleos de

hidrógeno. Rutherford sugirió que el núcleo de hidrógeno, cuyo

número atómico se sabía que era 1, debía ser una partícula fundamental. Se adoptó para esta nueva partícula el nombre de

protón sugerido en

1886 por

Goldstein para definir ciertas partículas que aparecían en los

tubos catódicos.

Durante la década de

1930,

Irène y

Jean Frédéric Joliot-Curie obtuvieron los primeros nucleidos radiactivos artificiales bombardeando

boro (

5B) y

aluminio (

13Al) con

partículas α para formar isótopos radiactivos de

nitrógeno (

7N) y

fósforo (

15P). Algunos isótopos de estos elementos presentes en la naturaleza son estables. Los isótopos inestables se encuentran en proporciones muy bajas.

En

1932 James Chadwick realizó una serie de experimentos con una radiactividad especial que definió en términos de corpúsculos, o

partículas que formaban esa radiación. Esta nueva radiación no tenía carga eléctrica y poseía una masa casi idéntica a la del protón. Inicialmente se postuló que fuera resultado de la unión de un protón y un

electrón formando una especie de

dipolo eléctrico. Posteriores experimentos descartaron esta idea llegando a la conclusión de que era una nueva partícula procedente del núcleo a la que se llamó

neutrones.

Los científicos alemanes

Otto Hahn y

Fritz Strassmann descubrieron la

fisión nuclear en

1938. Cuando se irradia uranio con neutrones, algunos núcleos se dividen en dos núcleos con números atómicos. La fisión libera una cantidad enorme de energía y se utiliza en

armas y

reactores de fisión nuclear.

REACCIONES NUCLEARES

Colisión inelástica

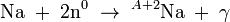

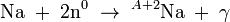

La física nuclear incluye también el estudio de las reacciones nucleares: el uso de proyectiles nucleares para convertir un tipo de núcleo en otro. Si, por ejemplo, se bombardea el

sodio con

neutrones, parte de los núcleos estables

Na capturan estos neutrones para formar núcleos radiactivos

²Na:

Estas reacciones se estudian colocando muestras dentro de los reactores nucleares para producir un flujo alto de neutrones (número elevado de neutrones por unidad de área).

Los núcleos también pueden reaccionar entre ellos pero, si están cargados positivamente, se repelen entre sí con gran fuerza. Los núcleos proyectiles deben tener una energía lo bastante alta como para superar la repulsión y reaccionar con los núcleos blanco. Los núcleos de alta energía se obtienen en los

ciclotrones, en los

generadores de Van de Graaff y en otros

aceleradores de partículas.

Una reacción nuclear típica es la que se utilizó para producir artificialmente el elemento siguiente al

uranio (

238U), que es el elemento más pesado existente en la naturaleza. El

neptunio (Np) se obtuvo bombardeando uranio con deuterones (núcleos del isótopo hidrógeno pesado,

2H) según la reacción:

Los núcleos atómicos consisten en protones, cargados positivamente y neutrones sin carga. El número de protones de un núcleo es su

número atómico, que define al elemento químico. Todos los núcleos con 11 protones, por ejemplo, son núcleos de átomos de

sodio (Na). Un elemento puede tener varios

isótopos, cuyos núcleos tienen un número distinto de neutrones. Por ejemplo, el núcleo de sodio estable contiene 12 neutrones, mientras que los que contienen 13 neutrones son radiactivos. Esos isótopos se anotan como

y

, donde el subíndice indica el número atómico, y el superíndice representa el número total de nucleones, es decir, de neutrones y protones. A cualquier especie de núcleo designada por un cierto número atómico y de neutrones se le llama

nucleido.

Los nucleidos radiactivos son inestables y sufren una transformación espontánea en nucleidos de otros elementos, liberando energía en el proceso (véase

Radiactividad).

Esas transformaciones incluyen la

desintegración alfa, que supone la emisión de un núcleo de

helio (

), y la

desintegración beta (que puede ser β

- o β

+). En la desintegración β

- un

neutrón se transforma en un

protón con la emisión simultánea de un

electrón de alta energía y un

antineutrino electrónico. En la desintegración β

+ un protón se convierte en un neutrón emitiendo un

positrón.

Por ejemplo, el

24Na sufre una desintegración β

- formando el elemento superior, el magnesio:

La

radiación gamma es radiación electromagnética de alta

frecuencia (y por tanto

energía). Cuando se produce la desintegración α o β, el núcleo resultante permanece a menudo en un estado excitado (de mayor energía), por lo que posteriormente se produce la desexcitación emitiendo rayos gamma.

Al representar la desintegración de un nucleido radiactivo se debe determinar también el

periodo de semidesintegración del nucleido. El periodo de semidesintegración del

, es de 15 horas. Es importante determinar el tipo y energía de la radiación emitida por el nucleido.

http://www.youtube.com/watch?v=PgssFYilO0M&feature=fvwrel

http://www.youtube.com/watch?v=PgssFYilO0M&feature=fvwrel

y

y  , donde el subíndice indica el número atómico, y el superíndice representa el número total de nucleones, es decir, de neutrones y protones. A cualquier especie de núcleo designada por un cierto número atómico y de neutrones se le llama

, donde el subíndice indica el número atómico, y el superíndice representa el número total de nucleones, es decir, de neutrones y protones. A cualquier especie de núcleo designada por un cierto número atómico y de neutrones se le llama  ), y la

), y la